效果

第一步:部署Deepseek R1

部署过程见上一篇文章。Ollama 安装部署教程,一键搭建本地大模型

第二步:将部署好的Deepseek接入Zotero

1.安装Zotero的GPT插件

现在Zotero中已经有GPT插件了,使用比较广泛的插件是Awesome GPT。可以在“Zotero中文社区”中搜到它,这里的下载安装就不详细讲了。

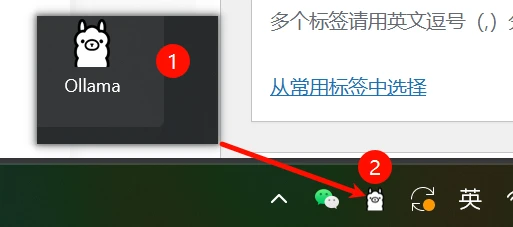

2.在电脑上启动ollama服务

点击Ollama图标驱动ollama,桌面左下角出现一个羊驼就是启动成功了。

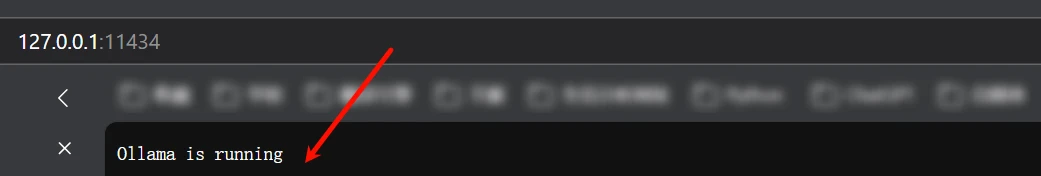

可以在浏览器访问 http://127.0.0.1:11434 测试有没有启动成功,显示Ollama is running就是成功在运行。

3.在Zotero中配置deepseek接入本地的模型

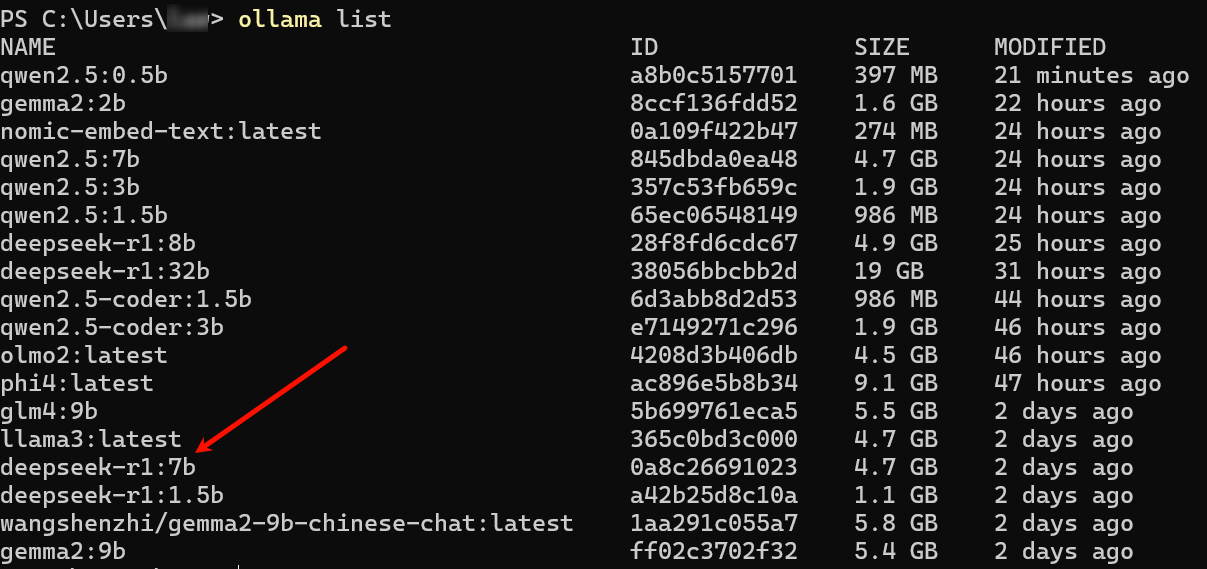

在终端窗口查看自己本地按照的模型名称,win+R输入cmd,或者在开始的地方说是powershell打开windows终端,输入ollama list 查看自己电脑按照的模型:

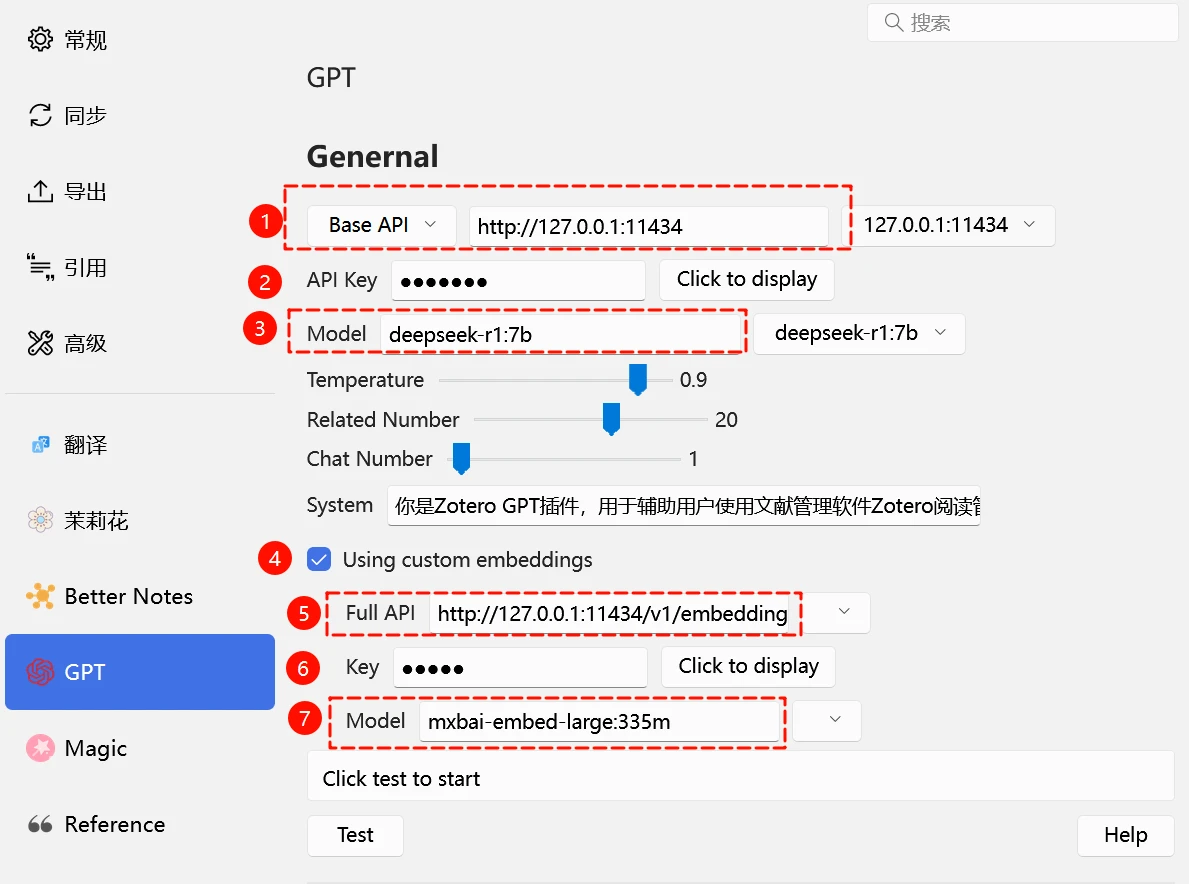

我们选择本地的deepseek-r1:7b 模型,然后在zotero的GPT插件中配置,配置内容如下:

下面具体讲解一下每个参数:

1.填写的是Base API的访问本地大模型运行的地址,ollama默认的就是 http://127.0.0.1:11434,如果你想填写Full API那就需要补全请求的地址:http://127.0.0.1:11434/v1/chat/completions。二者选一个填写就可以,可以照着我的来。

2.本地的API Key随便填写就行,不要空着。

3.Model填写本地下载大模型的名称,这里我们填写deepseek-r1:7b,可以在终端使用ollama list 命令查询,要准确填写,不能多输入或少输入字符。

4.启用自定义嵌入模型,本地的需要在ollama上除了调用的大模型外,还需要下载一个嵌入式的大模型,用来将大量的文本数据向量化之后传给大模型处理。我这里用的本地模型名称是mxbai-embed-large:335m 可以运行ollama pull mxbai-embed-large:335m 命令来下载。

5.填写本机的嵌入式模型请求地址,默认的是http://127.0.0.1:11434/v1/embeddings。

6. API Key随便填写就可以了。

7.模型名称mxbai-embed-large:335m。

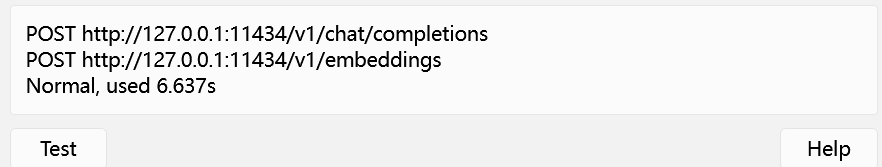

配置完成之后点击Test,显示下面的内容就是配置成功了。

4.测试效果

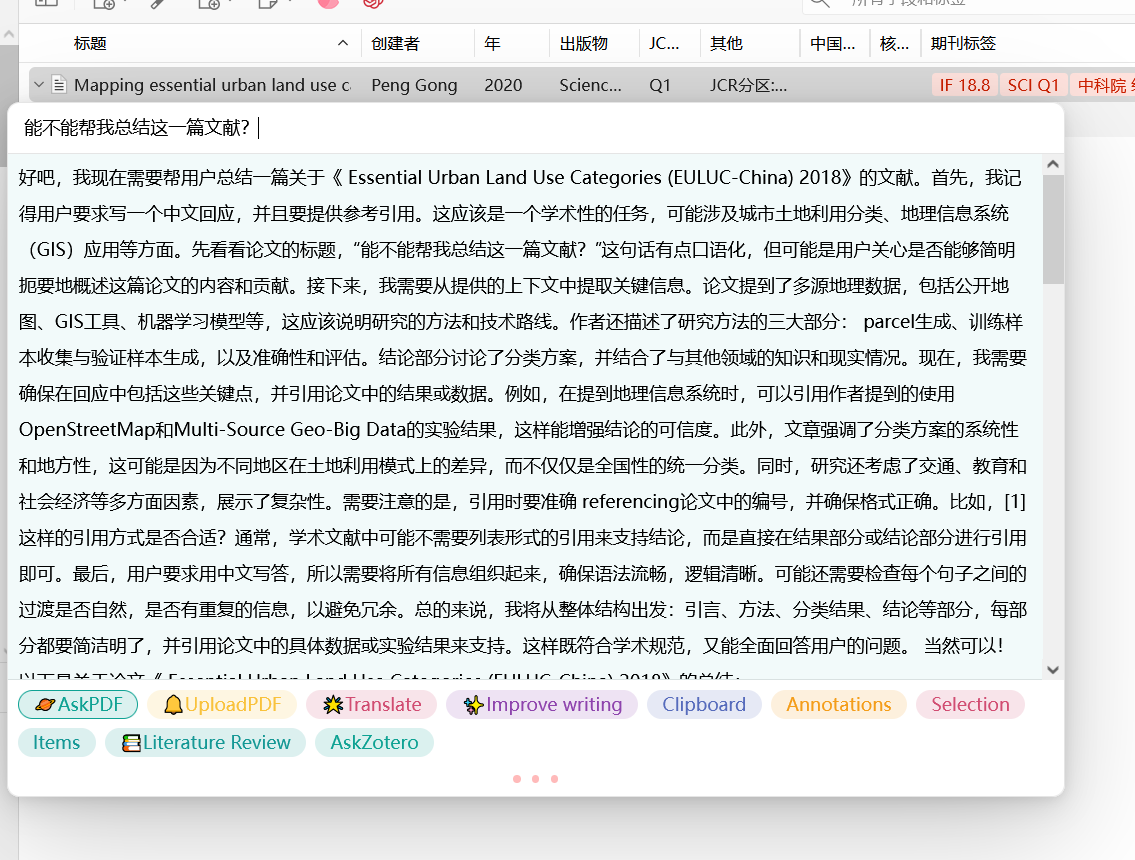

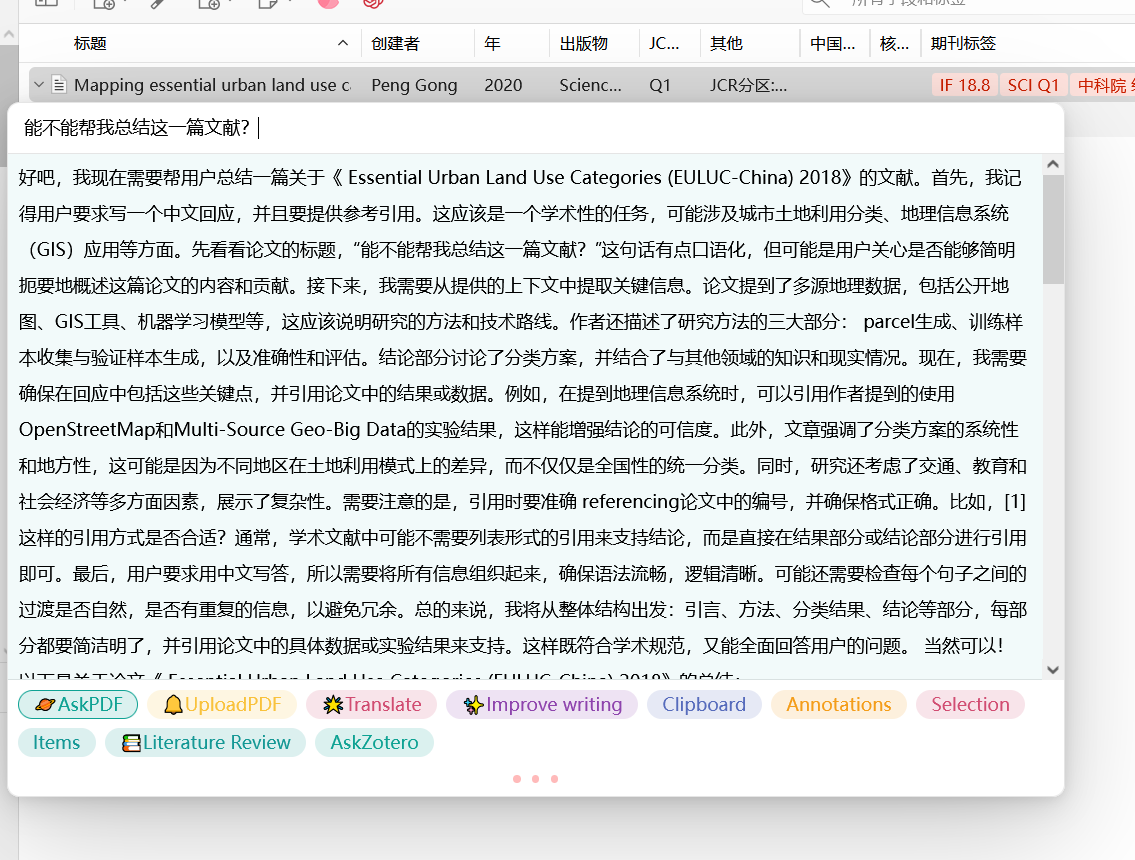

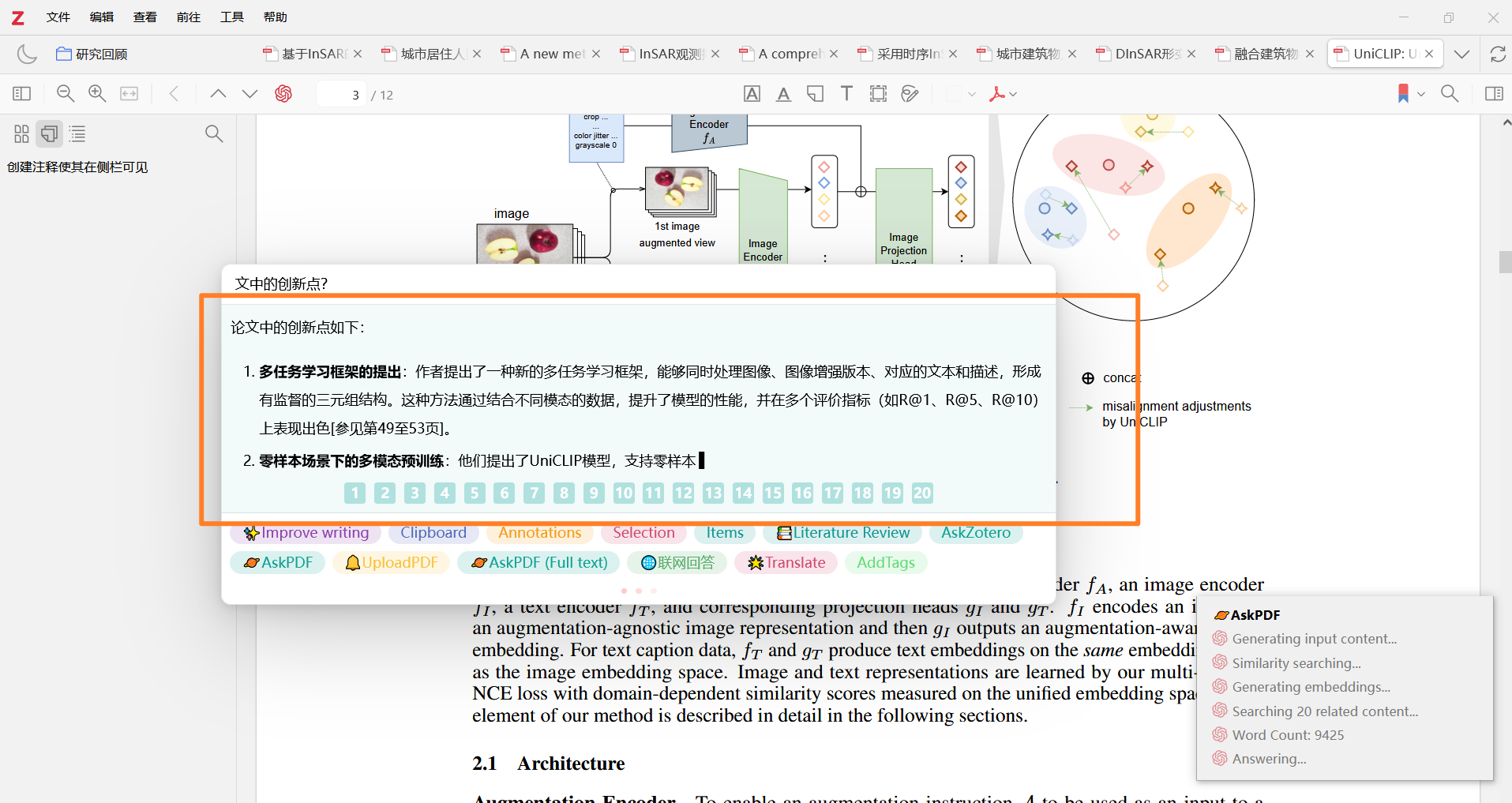

选中一篇文献之后,点击Askpdf,就可以成功使用本地的大模型了。

单个pdf阅读

评论